デヴィッド・ヒュームについて書いて以来、ずっとカントの著作と格闘している。これまで何回か読んだカントだが、特にヒュームを自分なりにしっかり整理した上で読み直すと、面白いし、問題もよくわかる。ただ、彼の著作だけでなく、彼に関する本も読もうとすると、カントについて書けるようになるまでまだまだ時間がかかる。

そこで最近世界中が大騒ぎしているChatGPTをとりあげることにした。GPT(generative pre-training transformer)と呼ばれる言語処理についてはこのHPで2度取り上げたことがある(後述)が、今のChatGPT騒ぎはレベルが違う。そこでこのAIの概略について理解しようと、Stephen Wolframが書いた「What is ChatGPT doing・・・」を読んでみた。

Stephan WolframさんがChatGPTについての彼の考えをわかりやすく示した本。Kindle版は無料。

Stephen Wolframは、自然現象のcomputer reducibility 理論や、物理法則を統合するためのハイパーグラフで有名な物理学・数学者で、そんな超有名な科学者が書いた解説書ということで飛びついた。大変優れた解説書で、ChatGPTの原理、可能性、課題などがうまく整理され、「ChatGPTは文章の次にくる単語を確率論的に予測するだけ・・・」などといった舌足らずの説明とはまったくちがう。

彼は、ChatGPTを言語や人間の思想という観点からも述べており、これを読んでいるとき、「ヒュームの哲学はChatGPTに具現しているのではないか、またカントによるヒューム批判がChatGPTの限界として具体的に示せるのではないか?」という突拍子もないアイデアが浮かんできた。すなわちGPTのような人間の言語世界を包含できるようなシステムは、例えば「人間の知性や理性が全て経験の結果か」といったヒュームの哲学的提起を、「GPTはどこまで人間か?」という課題に置き換えているのではと考えた。そしてこれが可能なら、ヒュームの概念は人工知能上で確かめることができることになり、合成哲学や哲学の実験哲学まで可能にする新しい道が開ける。もちろん哲学だけではない。人工知能に様々な機能を表象させることで、人間の脳や言語とは何かを合成的に知る事ができるのでは、とまで考えるようになった。このようなわけで、カントによるヒューム批判をChatGPTから眺めることを、生命科学の目で読む哲学書番外編にすることにした。

Wolframさんの「What is ChatGPT doing?」の要約

Open AI社のGenerative Pre-trained Transformer (GPT)-3.5ベースのChatGPTが公開されたのは2022年の暮れだが、瞬く間に世界1億人以上の人たちの心を掴んだ。これは単に便利だというのではなく、生成AIが「あなたの頭の中で構想し疑問に思ったことを、あなたの代わりになって、明瞭に、しかもわかりやすくあなたに提示してくれる」ポテンシャルを持つからだと思う。

なぜこれが可能かについてのWolfram博士の説明は以下のとおりだ。

「The first thing to explain is that what ChatGPT is always fundamentally trying to do is to produce a “reasonable continuation” of whatever text it’s got so far, where by “reasonable” we mean “what one might expect someone to write after seeing what people have written on billions of webpages, etc.” Wolfram, Stephen. What Is ChatGPT Doing … and Why Does It Work? (p.8). Wolfram Media, Inc. . Kindle 版.

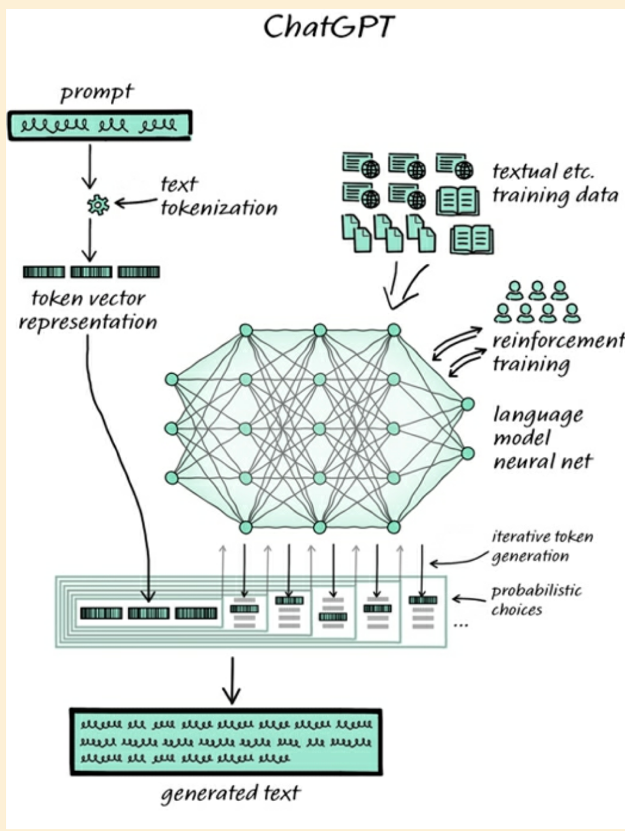

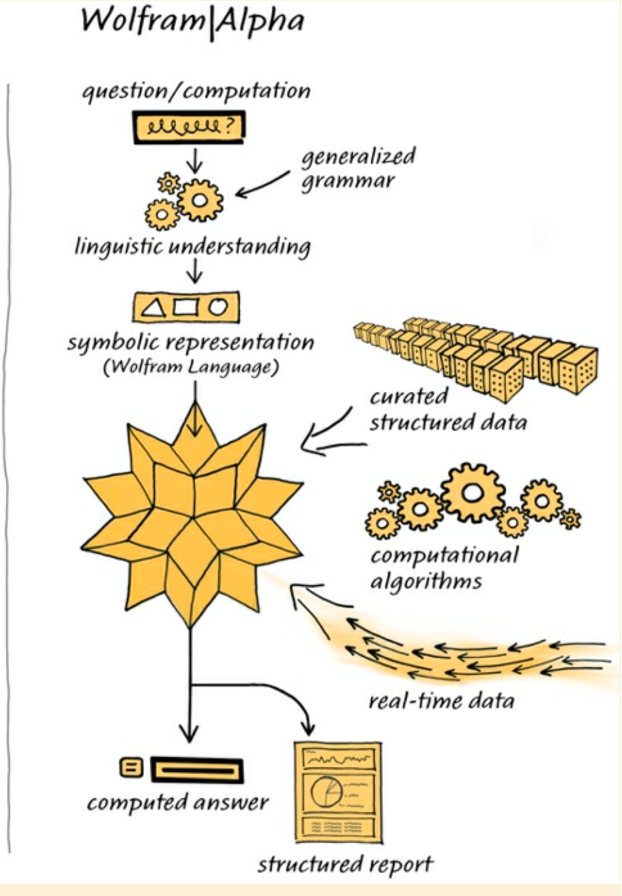

すなわち、「ChatGPTは与えられた文章を、なるほどと思えるように正しい文章で続けることができるように訓練されたニューラルネット」で、極めてシンプルな課題をこなすためのAIと考えればいい。ただ、これを可能にするために、ChatGPTは1700億を超すネットワークを擁し、学習した膨大な文章から、文章を構成する単語同士の関係を自分で読み取り、embeddingと呼ばれる数値化により、単語同士の関係を膨大な次元空間の中に配置し、文章が与えられると、トランスフォーマー(アテンション)と呼ばれる機能を用いて、最も蓋然性の高い続く文章を新たに紡ぎ出す。これらプロセスは自動で行われるが、こうして紡ぎ出された文章の意味がとれるかどうかは、最終的に人間がレビューし絶え間なくフィードバックを受けている(図は、彼の本から抜き書きしたもので、説明については直接彼の本を読んでほしい)。

WolframさんがChatGPTの説明に用いた図

Wolframさんの説明によると、ChatGPTは数千億の単語を文章(すなわち意味のあるつながり)として学習しており、このデータのなかの単語はさまざまなパラメーター数値で定義される個々のtokenとしてネットワークの中に表象されている。このパラメータはそれぞれの単語の言語空間の中の位置を表しており、これに基づいて文章がデコードされ、またエンコードされている。

こう理解すると、ChatGPTは与えられたニューラルネットのアルゴリズムに従い、膨大な文章を経験し、その経験により発達し(ネットワークのつながり強度を変化させる)、経験が深まれば深まるほど、どんな質問にも、文章的に意味のある答えを出すことができるようになることがわかる。

ChatGPTの場合、意味的に矛盾のない文章を作成することが最優先課題で、質問の答えは全て学習した文章の中から紡ぎ出されるため、常に正しい答えが出るわけではない。実際ChatGPTでは質問に対し間違った答え(例えば日本の首相の出身大学)出すことがよく問題にされるが、これは経験した中(おそらく英語)に、岸田首相と早稲田大学を結びつける文章がなかっただけで、その結果ネットワーク内で見つけた確率論的に最も関連の深い要素を、意味が損なわれないことのみを主眼に答えとして紡いでいるからになる。

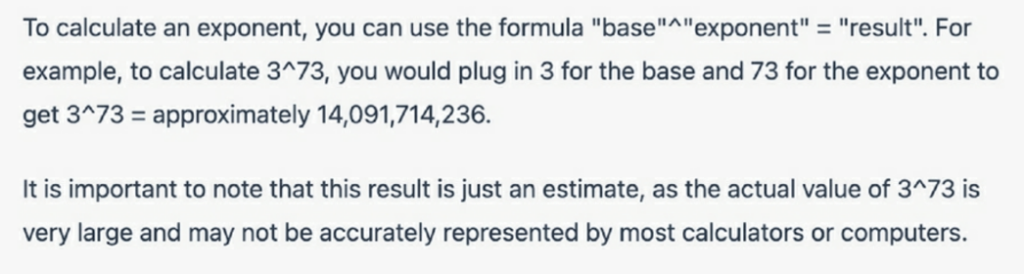

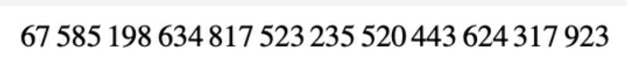

おそらくChatGPTで使われる確率論的処理の問題を最もよく表すのが、計算のような抽象的な処理が苦手な点だ。Wolframさんは「3の73乗を計算せよ」という課題を例として挙げている。あえて訳すのは控えるが、ChatGPTの答えは

だそうだ。すなわち関連する文章を見つけてきて答えを出しており、決して計算はしていないことがはっきりする。自分の問題を誤魔化すため、与えた答えがかならずしも正確ではないことまで断って予防線を張るのも怠らない。実際の答えは遥かに膨大な以下の数字になる。

しかし、計算という抽象的作業を避けて、ひたすら文章の中に答えを見つけようとするのは面白いし、間違っていてもともかく答えを出すのにも驚く。ただ、必ず答えを出さなければならないというChatGPTの使命は、間違うとChatGPTを神やビッグブラザーの位置に押し上げる心配もあるので注意が必要だ。

デビッド・ヒュームの経験論とChatGPT

私の理解はすこし歪んでいるかもしれないが、上記のようにChatGPTを理解してしまうと、ChatGPTは人間の知性や理性を言語的経験のみで形成できることを示すための壮大な実験のように見える。人間と機械を区別するためのチューリングテストは有名だが、感情要因を引き算して残るのが、知性や理性で、それをもとに人間と機械を区別できるかがこの課題で問われるとすると、おそらく現在のChatGPTはチューリングテストをクリアしているのではないだろうか。すなわち、1億人以上の人が利用して、Chatを繰り返しているとすると、この実験は大成功に終わっている。

しかも人間と同じ知性や理性が、感覚を通さずに言語化された経験のみで獲得できることまでChatGPTの成功は明らかにした。こう考えた上でWoframさんの解説を改めて思い起こすと、ChatGPTがめざしている課題、すなわち経験のみで人間と同じ知性を形成させる可能性は、そのまま前回紹介したデビッド・ヒュームの経験論(https://aasj.jp/news/philosophy/21273)の課題とオーバーラップする。

前回書いたヒュームの哲学をおさらいしてみよう。彼の思想は3つの柱からできている。まず、人間の知性や理性の起源は全て経験に由来する。さらに、デカルトにはじまる合理主義哲学の根幹である、外界と対峙する自己を否定し、自己とは各個人の基質(タブラ・ラサ)に集められたそれまでの経験の塊でしかないと言ってのける。そして最後に、個人の経験と他人の経験との共通性は、それぞれの事象の背景にある因果性(事象同士の関係)が保証していると考える。ただ、この因果性とは決してyes/noと白黒をつけられるものではなく、一定の蓋然性の枠で考えるべきだとした。

ヒュームの思想3本の柱を踏まえた上で、ChatGPTをもう一度見直してみよう。1700億結合を持つニューラルネットがその基礎にあるが、各結合の度合いは経験を通して変化し、学習した言語世界を大きな統計データとしてネットワークに保持する。従って経験によりネットワークの結合性は変わり(この変化が言語世界を表象する)、経験が異なればネットワークの独自性も生まれるが、経験なしにはネットワークは存在しない。すなわち、ニューラルネットという基質は同じで、経験により異なる知性や理性が生まれることを実験的に示している。そして、今日の自分は新しい経験を経た明日の自分と異なっているという点でも、ヒュームの自己概念と同じだ。

言い換えると、ヒュームの経験論を徹底的に単純化するとChatGPTになる。ヒュームにとって経験を受け入れるニューラルネットワークに相当するものがなんだったか明確ではないが、我々が今考える脳と同じような基質を想定していたのではないだろうか。もちろん人間の脳とChatGPTとの大きな相違は、ChatGPTの場合、全ての経験が言語だけを通して学習される点だ。人間に例えれば、視覚、聴覚、触覚など全ての感覚がないが、直接脳内に文字列をインプットする仕組みを持っていることになる。しかし、言語世界がインプットできれば、それぞれの単語や文章の意味を教えなくとも、言葉の並びの法則から、言葉や文章を意味のレベルで整理し、保持することができる。ChatGPTがそれを意味として認識する必要は全くないが、そこから生まれる文章は(間違っているかどうかは別として)我々が意味を持つと判断できるように設計されている。

この事実は、言語世界に、視覚や聴覚も含め人間の感覚が表象として組み込まれており、見なくとも聞かなくとも、ChatGPTが人間の感覚や知性を経験させることが出来ることを意味する。このように、ChatGPTという実験が、まさに言語とは何かについても、新しい切り口を与えてくれるとがわかる。

加えて、ChatGPTが学習した文章から、自動的に単語同士の統計学的関係性を計算し言語世界を表象していることにも、ヒュームが重視した因果性概念との一致を感じる。すなわち、ChatGPT内での言語要素の関係性と確率は、そのまま言語世界に表象された様々な現象の関係を因果性も含めて表している。見た目は大きく違っているように思えるが、ヒュームが主観的経験の共有化のために必須と考えた、事象間の因果性にかかわる蓋然的因果関係の概念が、全く新しい形でChatGTPのトークン間の関係によみがえっているように感じる。このように、ChatGPTこそ、「経験論でどこまで人間の知性を説明できるか?」というこれまでの哲学的課題に対する初めての実験的チャレンジではないかと思う。

ChatGPTに具現した経験論がどこまで人間の理性を説明できるのか?カントのヒューム批判。

このようにChatGPTを究極の経験論として位置づけると、次の問題は当然「人間の理性は経験だけで説明できるのか?」というカントのヒューム批判をChatGPTに当てはめることになる(哲学としては次回カントについてまとめるまで待ってもらうとして、ここでは極めて単純化して話を進める。)カントにとっては経験だけで人間の理性が形成できるとは考えられなかった。例えば、万人共通に持つ空間や時間の概念、人間が生きるための目的や道徳のような実践原理、さらには美や生命など、経験だけで獲得されるとは到底考えられなかった(絶対理性としての時空概念は人工知能と絡めてあまり議論されない様に思うが、AIに道徳があるのか、美の概念があるのか、などについては常に議論が続いているのを思い出そう)。

そこでカントが最初に持ち出したのが、経験を超えた絶対的理性の数々で、その例として、すなわち先見的な理性として示したのが、空間と時間、そして数学的概念だった。ただ、空間や時間認識が、絶対的理性の形式なのか、ヒュームが考えたように実際には経験から判断できるのか、哲学的議論だけで結論を出すのは難しい。結局、カントが主張するように、経験とは別に絶対理性が存在するという考えが正しいのか、正しくないのかは本当はわからないままだ。

例えばChatGPTに我々と同じ空間認識に従った絵が描けるという事実は、カントが絶対的理性様式として考えた空間概念を、経験論の塊であるChatGPTも表現できることを示しているように見える。しかしこれはChatGPTに我々の言語世界が包含され、その言語世界に我々の感覚が表象されているとしたら当然のことだ。

では、カントの経験論批判は的外れなのか?ここで思い出してほしいのは、Wolfram さんがChatGPTの最大の問題として指摘している、計算ができないという特徴だ。すなわち、事象の抽象的処理ができない。1+1ですら、言語世界の中に存在している文章の中に答えを求める必要がある。1+1であれば、2という答えが様々な文章に書かれており、例えば3と答えた文章も混じっていたとしても、確率論的に2という答えに到達できる。しかし、3の73乗のような計算になると、いかに数千億の単語を学習していたとしても、見つかるはずはない。

数学と同じで、空間や時間も基本的には抽象的形式といえる。とすると、カントは見事に究極の経験論ChatGPTの抱える問題を見通していたことになる。すなわち、経験した事象の蓋然的関係性だけでは、抽象的な理性は生まれようがない。重要なのは、確率的言語モデルだけで経験した人工知能では、抽象的処理が難しいことを実験的に示せるという点で、ここに新しい哲学の可能性が示されている。

では、抽象的な処理はAIには不可能なのか?もちろん可能で、これにチャレンジしているのがWolfram さんだ。彼はcomputer reducibleな世界、すなわち計算式で全ての世界を表現するためのWolfram言語システムを開発している。私は詳細について理解しているわけではないが、彼の本の最後に、ChatGPTの目指すところと、Wolfram/alphaが目指すところが対比されているので紹介したい。

まず驚くのは、統計的言語モデル全盛の時代に、自然言語に計算処理を適用するため、文法、すなわちシンタックスベースの処理システムを導入している点だ。このように、この人工知能は全ての合理世界を計算可能性で判断し、計算可能な世界を構築していく。まさにチューリングマシンの思想を究極まで追求しているように思える。

ここで行われる処理の具体的内容は理解できていないが、Wolfram/alphaがcomputer reducibilityにあえて固執することの重要性はわかる。例えばChatGPTが空間や時間を含んだ絵を描いたとしても、人工知能が空間を認識しているかどうかはわからない。これは統計学的蓋然性だけに答えを求めるAIの宿命だ(実際学習した内容により答えは変わる)。極論すれば、論理が全くない内容に対しても問題なく答えが出る。しかし、computer reducibility を判断基準にすることで、reducibleかirreducibleかの判断が下される。すなわち、understanding(哲学的には悟性や知性と呼ばれる)が備わっていることになる。

同じように、構造化されたデータをレファレンスに用いて、リアルデータのcomputer reducibility をチェックする点も、Understandingを生み出す。考えてみれば、私たちはunderstanding できないことは(深層には維持されるかもしれないが、)結局脳ネットワークから排除している。

Wolframさんが彼のWolfram/alphaを説明した図

最後に、このシステムでは単語を統計学的に数値化されたトークンとして扱うのではなく、シンボル(もともと言語はシンボルなのだが)として扱う点も、もともとわたしたちが持っていた言語概念に近く、期待できる気がする。

以上、ChatGPTやWolfram/alphaについて少しかじってみると、ヒュームの経験論や、カントの絶対理性の概念を、人工知能として実験的に確かめることが可能な時代がきたのではないかと思える。

人間の脳とChatGPTの比較

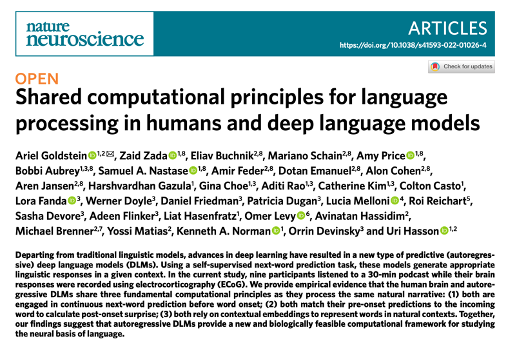

ここまでChatGPTも、Wolfram/alphaも人工知能の話で、哲学を生み出した人間の脳の話と決めるわけにはいかない。そこで人間の脳とAIがどこまで同じかについて少し考えてみよう。思い起こして欲しいが、私も昨年3月GPTについて面白い論文を紹介している(https://aasj.jp/news/watch/19237)。論文ではChatGPTより一世代前のGPT2を使っているが、GPT-2による言語処理と、同じ文章を聞いた時の我々の脳(主に言語野)の反応を比べ、なんと私たちの脳もGPT-2と同じように文章を処理していることを示した論文だ。すなわち、我々の脳も逐次的にそれまで聞いた文章の次を予測し、その結果をネットワークにフィードバックする作業を繰り返していることを、脳内に設置したクラスター電極を用いてあきらかにしている。

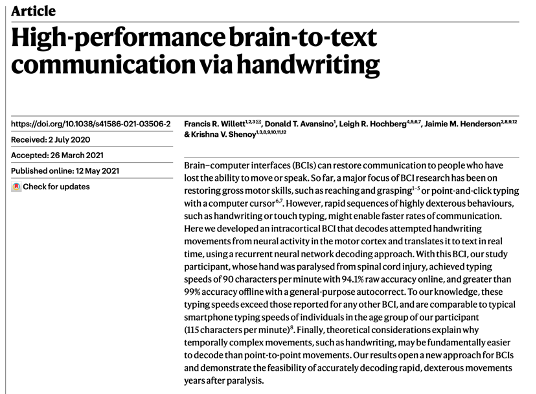

さらに人間の脳研究を見てみると、AIは脳の活動を行動へとデコードするためには欠かせない方法になっている。例えば、以前紹介したように(https://aasj.jp/news/watch/15671)、脳内に100程度のクラスター電極を留置し、文字を書いている時の脳活動をAIに学習させると、今度は脳内に学習したパターンが現れたときに、文字と対応できるようになり、なんと頭の中で考えた文章を、1分間に100を超えるアルファベットを99%の正確さでタイプできる。

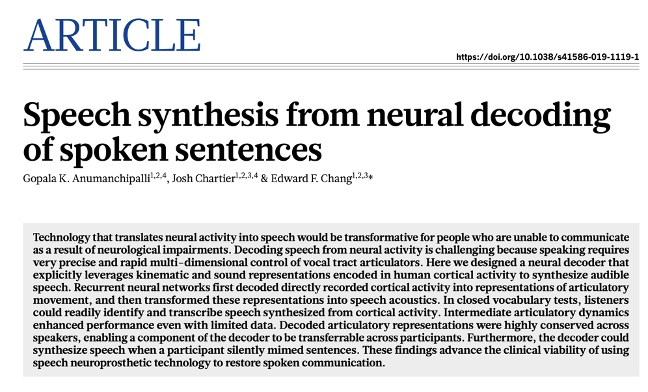

これは考えたことを書いてくれるAIだが、2019年には考えたことを言葉にして発声するAIもNatureに報告されている。

以上のように、AIを使えば理屈はともかくとして、我々の脳をデコードすることが出来る。

極めつけは、文章を聞いている脳反応を、MRIという恐ろしく時間解像度の低い方法で検出し、その結果をトークン化し、それに続く文章をGPTで生成し、その文章の意味と、実際聞いた文章との違いを検出してフィードバックすると、16時間程度の学習でデコーダーが脳の活動から、その人の頭に浮かんだ文章を抽出してくれるという、すなわち頭の中の考えすらAIでデコードできるという論文だろう(https://aasj.jp/date/2023/05/08)。

このように、脳活動をデコードする目的にAIは欠かせない。ただ、AIやGPTで脳の活動をデコードできたからと言って、脳がインプットやアウトプットをAIと同じ確率論的関係性を元にエンコード/デコードしているのかはわからない。というのも、脳活動をデコードするとき記録している活動は脳全体の活動の一部で、その断片からだけデコードする場合は確率論的AIに頼らざるを得ないからだ。

しかしオキーフさんや、モザー夫妻の研究から明らかになったように、感覚からインプットされた場所やグリッドは、海馬の神経ネットワークの空間的配置として表象される。また時間にしても、概日周期だけでなく、様々なリズムが脳回路で刻まれている証拠はある。例えば言語や音楽を聴いているときのN400反応といった正確な時間反応は、時間がネットワークの中に表象されている可能性を示す(https://aasj.jp/news/watch/8178)。おそらく、代数などの抽象的計算や幾何学的課題を行う時の脳活動も同じで、記憶している膨大な結果の中に答えを探すというやり方を否定する必要はないが、統計学的処理とは異なるアルゴリズムが用いられている可能性が十分存在するように思う(この点については調べていない個人的印象)。

このように統計学的処理によるAI全盛の時こそ、AIを用いたデコードにより説明できるかどうかだけで納得しない脳科学が必要だと思う。また、この可能性を追求するために、抽象的処理にこだわったWolfram/alphaのような人工知能は、脳ネットワークの活動を考えるためのレファレンスとして面白いのではないだろうか。例えば文法をベースにした計算を元に言語処理が行われているとすると、良く似た処理を脳が採用していないかは面白い課題になる。

こう考えてくると、ChatGPTを学ぶ中で突拍子もなく浮かんだヒュームとカントの議論は、詰まるところ我々の脳の高次機能の問題であり、そこに行くまでにまず人工知能のアルゴリズムの問題として実験的に確かめられるかも知れない。

終わりに

Wolframさんの本を読んでいるとき、突然頭に浮かんだ、「ヒュームとカントの議論を、2種類の人工知能のアルゴリズムの違いの問題に移して考えられるのでは?」という私の突拍子もない妄想に、納得いただけただろうか。もしこれが可能なら、人工知能のアルゴリズムと、人間の脳ネットワークをさらに比較することで、「ヒュームとカントの議論」を脳科学の問題として捉えられるかも知れない。もちろん哲学者は反対すると思うが(例マルクスガブリエル「私は脳でない」https://aasj.jp/news/philosophy/12813)、「生命科学の目で見る哲学書」を書いてきた私の動機は、まさにこれだ。ただ、哲学議論をそのまま脳科学に移してしまうと、説明は可能なのだが、表面的で、脳科学が十分進んでいない以上、哲学議論を繰り返すのと変わりがないことになる。

しかし、今回見たように、より操作が可能な人工知能に哲学問題を移せるとしたら、より実験的に問題にアプローチできる。その意味で、人間の知性は全て経験のみにより形成されるとするヒュームの思想やその問題が、ChatGPTとして実験的に確かめられるとすると、これまで議論以外に方法がなかった哲学のあり方に、全く新しい光がさすと言えないだろうか。既に述べたように、ChatGPTはチューリングテスト的には人間の行動と変わるところはなく、その意味で膨大な経験の塊を代表している。

ところがWolframさんが指摘したように、そしてヒュームに対してカントが批判したように、経験のみから生まれる知性には抽象的処理が出来ないという問題が、人工知能のアルゴリズムの検討から明らかになる。もちろんカントが指摘した絶対的理性が、Wolfram/alphaの人工知能に移せるのかどうか私にはわからない。しかし、人工知能の新しい課題として、十分実験可能な課題といえる。

同じように、人間社会に人工知能を適応させるため、道徳などを人工知能にどう導入するかが議論されている。しかしこの議論は、素人の私から見ても、単純な学習の問題としてすませているように思う。考えてみると、道徳概念や科学的概念などは、人間と人間の間の対話を基礎に生まれる。ところが現在の人工知能は、一つのネットワークに学習させるという点に主眼が置かれ、人工知能間の対話という発想はあまりないため、おそらく自然に新しい道徳概念や科学概念が生まれるようには思えない。

幸い人間にフレンドリーな人工知能を目指すChatGPTもWolfram/alphaも、ともに自然言語をインプット、アウトプットに使うよう設計されている。とすると、今後使用されているアルゴリズムを超えて、人工知能間の対話が可能になるかも知れない。これが実現すると、おそらく道徳とは何か、あるいは人工知能で新しい科学的概念を生み出せるかと言った問題に実験的にアプローチできるかも知れないと妄想してしまう。

最近になってChatGPTについて知るまで、人工知能の可能性について、便利という以外に考えたことがなかったが、今始めて人間を理解するための新しい方法論が生まれたと実感している。人間を人間たらしめる、言語、道徳、科学などがどう生まれるのか、ひょっとしたら生きている内に理解できる日が来るのではと期待している。